Architecture Microservices Full-Stack : De la conception au déploiement

Sommaire

Backend - Écosystème Microservices

- Spring Cloud Gateway - Implémentation Load Balancer avec Gestion CORS

- Architecture des Microservices

- Communication inter-services

- Gestion avancée des déploiements - Script deploy.sh

- Orchestration intelligente - Script wait_for_config.sh

- Stratégies Docker Swarm avancées

- Pipeline d'intégration continue complète

- Registry Nexus intégration

- Monitoring et observabilité conteneurisée

- Logging et persistence

Introduction

Dans le cadre de mes projets de développement, j'ai conçu et développé une application moderne suivant une architecture microservices complète. Ce projet illustre ma maîtrise des technologies full-stack actuelles et des bonnes pratiques DevOps.

Problématique : Développement d'une plateforme de publication d'articles avec gestion fine des droits utilisateurs. L'objectif était de créer un système où les utilisateurs authentifiés disposant des permissions appropriées peuvent créer et publier des articles, tandis que les visiteurs anonymes peuvent consulter le contenu publié. La gestion de l'authentification et des autorisations est centralisée via Keycloak pour garantir la sécurité et la scalabilité du système.

Solution technique : Une architecture découplée combinant une SPA Angular moderne avec un écosystème de microservices Java, le tout orchestré par Spring Cloud Gateway et déployé via une pipeline CI/CD automatisée.

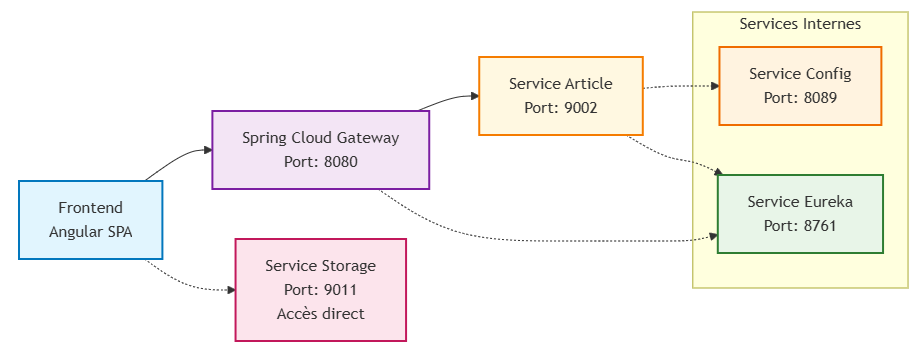

Vue d'ensemble de l'architecture

Pourquoi cette architecture ?

- Scalabilité : Chaque microservice peut évoluer indépendamment

- Maintenance : Séparation claire des responsabilités

- Résilience : Isolation des pannes

- Technologies adaptées : Chaque service peut utiliser la stack la plus appropriée

Frontend - Angular SPA

Technologies utilisées

- Angular 18.2.12 avec TypeScript 5.5.4

- RxJS 7.8.1 pour la programmation réactive

- Tailwind CSS 3.4.1 avec le plugin Typography pour le styling

- Flowbite 2.5.2 pour les composants UI

- FontAwesome pour les icônes

- Syncfusion RichTextEditor pour l'édition d'articles

- Keycloak Angular 16.1.0 pour l'authentification et autorisation

- Highlight.js pour la coloration syntaxique du code

- DOMPurify pour la sécurisation du contenu HTML

- ngx-pagination pour la pagination des articles

- Le Dépôt du projet : Projet Github:

Caractéristiques principales

1. Architecture et State Management avec RxJS

J'ai opté pour un Service Store pattern personnalisé utilisant RxJS plutôt que NgRx, offrant une solution plus légère et parfaitement adaptée aux besoins du projet.

Principe de fonctionnement :

@Injectable({

providedIn: 'root',

})

export class ArticleService {

// État privé avec BehaviorSubject

private articleSubject = new BehaviorSubject<Article>(new Article());

private domainSubjet = new BehaviorSubject<Domain[]>([]);

// Observables publics pour les composants

public article$: Observable<Article | null> = this.articleSubject.asObservable();

public domain$: Observable<Domain[]> = this.domainSubjet.asObservable();

Synchronisation automatique API ↔ État local :

saveArticle(article: Article): Observable<ResponseApi<Article>> {

return this.http.post<ResponseApi<Article>>(url, article).pipe(

map((responseApi: ResponseApi<Article>) => {

// Synchronisation immédiate de l'état local

this.articleSubject.next({ ...article });

return responseApi;

})

);

}

updateArticle(article: Article): Observable<ResponseApi<Article>> {

return this.http.put<ResponseApi<Article>>(url, article).pipe(

map((apiResponse: ResponseApi<Article>) => {

// Mise à jour de l'état après modification

this.articleSubject.next({ ...article });

return apiResponse;

})

);

}

Avantages de cette approche :

- Simplicité : Pas de boilerplate complexe comme NgRx

- Réactivité : Les composants se mettent à jour automatiquement via les observables

- Centralisation : Un seul point de vérité pour l'état des articles

- Performance : Évite les re-renders inutiles grâce à BehaviorSubject

2. Sécurité et Intégration Keycloak

L'authentification et l'autorisation sont centralisées via Keycloak avec une architecture robuste gérant l'ensemble du cycle de vie des tokens et la protection granulaire des ressources.

CustomKeycloakInterceptor - Gestion automatique des tokens :

L'intercepteur analyse intelligemment chaque requête HTTP pour déterminer si elle nécessite une authentification :

@Injectable()

export class CustomKeycloakInterceptor implements HttpInterceptor {

private privateEndpoints = [

"/articles/update",

"/articles/update/meta",

"/articles/save",

];

intercept(

req: HttpRequest<any>,

next: HttpHandler

): Observable<HttpEvent<any>> {

// Vérification si l'endpoint nécessite une authentification

const isPrivate = this.privateEndpoints.some((endpoint) =>

req.url.endsWith(endpoint)

);

if (isPrivate) {

// Récupération et injection automatique du token

return from(this.keycloak.getToken()).pipe(

switchMap((token) => {

const clonedReq = req.clone({

setHeaders: { Authorization: `Bearer ${token}` },

});

return next.handle(clonedReq);

})

);

}

return next.handle(req); // Requêtes publiques sans modification

}

}

Avantage : Cette approche évite d'ajouter systématiquement le token à toutes les requêtes, optimisant ainsi les performances et la sécurité.

Guards d'authentification - Protection des routes sensibles :

Le guard vérifie l'état d'authentification avant d'autoriser l'accès aux routes protégées :

export const authGuard: CanActivateFn = async (route, state) => {

const authService = inject(KeycloakOperations);

const router = inject(Router);

// Vérification basée sur le localStorage pour éviter les problèmes d'initialisation

const isAuthenticated = authService.isAuthenticated();

return isAuthenticated ? true : router.navigate(["/"]);

};

Fonctionnement : Le guard utilise le localStorage plutôt que directement Keycloak pour éviter les problèmes de timing lors de l'initialisation de l'application.

Gestion du refresh token automatique et transparente :

Le système écoute les événements Keycloak pour gérer automatiquement l'expiration des tokens :

initializeTokenRefrech() {

this.keycloakService.keycloakEvents$.subscribe({

next: (event) => {

if (event.type == KeycloakEventType.OnTokenExpired) {

this.logger.log('Le Token a expiré', 'KeycloakOperations');

this.refreshToken(); // Refresh automatique et transparent

}

}

});

}

refreshToken() {

this.keycloakService.updateToken(20)

.then((refreshed) => {

if (refreshed) {

this.logger.log('Token rafraîchi', 'KeycloakOperations');

}

});

}

Bénéfice : L'utilisateur n'est jamais interrompu par des déconnexions intempestives, le refresh s'effectue en arrière-plan.

Filtrage des requêtes selon les endpoints et permissions :

La logique de filtrage se base sur une liste prédéfinie d'endpoints sensibles :

- Endpoints publics : Consultation d'articles, domaines → Pas de token requis

- Endpoints privés : Création, modification, suppression d'articles → Token obligatoire

- Granularité fine : Chaque endpoint peut avoir ses propres règles d'autorisation

Cette architecture garantit une sécurité optimale tout en préservant les performances en évitant l'envoi inutile de tokens sur les requêtes publiques.

3. Gestion robuste des erreurs et observabilité

Le projet intègre un système complet de gestion d'erreurs et de traçabilité pour assurer une expérience utilisateur optimale et faciliter la maintenance.

ErrorHttpService - Gestion centralisée des erreurs HTTP :

Service centralisé qui traite uniformément toutes les erreurs HTTP avec des messages contextuels selon le statut :

@Injectable({

providedIn: "root",

})

export class ErrorHttpService {

public handlerError(error: HttpErrorResponse): Observable<never> {

let errorMessage!: string;

if (error.error instanceof ErrorEvent) {

// Erreur côté client (réseau, connexion)

errorMessage = `message => ${error.error.message} | filename => ${error.error.filename}`;

} else {

// Erreur côté serveur avec messages personnalisés

errorMessage = this.getServerErrorMessage(error);

}

console.error("Une erreur s'est produite :", errorMessage);

return throwError(() => new Error(errorMessage));

}

public getServerErrorMessage(error: HttpErrorResponse): string {

switch (error.status) {

case 404:

return `Not Found: ${error.message}`;

case 403:

return `Access Denied: ${error.message}`;

case 500:

return `Internal Server Error: ${error.message}`;

default:

return `Unknown Server Error: ${error.message}`;

}

}

}

LoggerInterceptor - Traçage des requêtes sortantes :

Intercepteur qui enregistre automatiquement toutes les requêtes HTTP pour faciliter le debugging et le monitoring :

@Injectable()

export class LoggerInterceptor implements HttpInterceptor {

constructor(private logger: LoggerService) {}

intercept(

req: HttpRequest<any>,

next: HttpHandler

): Observable<HttpEvent<any>> {

// Traçage automatique de chaque requête sortante

this.logger.log(`Request URL: ${req.url}`, "LoggerInterceptor.intercept");

return next.handle(req);

}

}

LoggerService adaptatif selon l'environnement :

@Injectable({

providedIn: "root",

})

export class LoggerService {

log(message: string, ...params: any[]): void {

if (environment.enableDebugLogs) {

console.log(message, ...params); // Logs uniquement en développement

}

}

error(message: string, ...params: any[]): void {

console.error(message, ...params); // Erreurs toujours affichées

}

}

Notifications utilisateur contextuelles :

Système de notifications réactif qui s'adapte aux opérations en cours :

@Injectable({

providedIn: "root",

})

export class NotificationService {

private notifSubject = new BehaviorSubject<PopupConfig>(null);

public notif$ = this.notifSubject.asObservable();

showMesg(msg: PopupConfig) {

this.notifSubject.next(msg); // Notification réactive vers les composants

}

}

Exemple d'utilisation contextuelle :

// Dans ArticleService - Notification lors d'une suppression

deleteArticle(article: Article): boolean {

this.http.delete<ResponseApi<Number>>(url).subscribe({

next: (response: ResponseApi<Number>) => {

this.notifService.showMesg({

isOpen: true,

title: '',

messages: [

`La suppression de l'article : ${article.idArticle} a été réalisée avec succès`,

`Cliquez sur fermer pour être redirigé vers la page d'accueil`

],

});

}

});

}

Messages de maintenance prédéfinis pour une meilleure UX :

Messages d'erreur utilisateur-friendly intégrés dans les services pour améliorer l'expérience :

// Dans ArticleService - Message de maintenance prédéfini

public errorArticleList: string =

'<div class="text-lg font-bold mb-1">Le service est momentanément indisponible pour cause de maintenance</div>' +

'<div class="text-sm">De retour en ligne prochainement... Nous vous remercions de votre patience.</div>';

Cette architecture garantit une observabilité complète du système tout en préservant une expérience utilisateur de qualité même lors de dysfonctionnements techniques.

Backend - Écosystème Microservices

Choix architectural et justification technique

Cette architecture microservices s'articule autour de 5 services distincts basés sur Spring Boot 2.4.5, conçue spécifiquement pour un déploiement sur Docker Swarm :

Composition de l'écosystème :

- Spring Cloud Gateway V2.4.5 - Point d'entrée et load balancer

- Spring Cloud Config V2.4.5 - Serveur de configuration centralisée

- Spring Cloud Netflix Eureka V2.4.5 - Service de découverte et registre

- Service Article V2.4.5 - Gestion des articles et contenu

- Service Storage V2.4.5 - Gestion du stockage et des fichiers

Rationale technique

Contraintes de l'orchestrateur Docker Swarm :

Contrairement à Kubernetes qui intègre nativement des mécanismes de service discovery et de gestion de configuration, Docker Swarm ne dispose pas de registre interne permettant l'enregistrement dynamique des microservices ni de système de configuration centralisée équivalent aux ConfigMaps/Secrets Kubernetes.

Solutions architecturales adoptées :

Spring Cloud Netflix Eureka comble cette lacune en fournissant :

- Service Registry : Enregistrement automatique des instances de services

- Service Discovery : Localisation dynamique des services pour le Gateway

- Health Monitoring : Surveillance de l'état des services enregistrés

- Load Balancing : Répartition intelligente de charge basée sur les instances disponibles

Spring Cloud Config centralise la gestion des configurations :

- Configuration externalisée : Stockage des propriétés dans un dépôt Git dédié

- Gestion multi-environnement : Profils de configuration par environnement (dev, staging, prod)

- Mise à jour à chaud : Rechargement dynamique sans redémarrage des services

- Versioning : Traçabilité des modifications de configuration via Git

Architecture résultante :

Cette approche permet de bénéficier des avantages des microservices dans un environnement Docker Swarm en recréant les fonctionnalités manquantes via les composants Spring Cloud. Le Gateway peut ainsi découvrir automatiquement les services via Eureka et équilibrer la charge entre les instances multiples, tandis que chaque service récupère sa configuration spécifique depuis le serveur Config centralisé.

Spring Cloud Gateway - Implémentation Load Balancer avec Gestion CORS

Vue d'ensemble de l'implémentation

Dans cette architecture, le Spring Cloud Gateway est configuré comme un Load Balancer intelligent avec une gestion CORS avancée. Contrairement à une approche où la sécurité serait centralisée au niveau de la Gateway, j'ai opté pour une délégation de la sécurité aux microservices sous-jacents, permettant une granularité fine et une meilleure séparation des responsabilités.

Responsabilité : Point d'entrée unique et load balancer intelligent de l'écosystème microservices, gérant le routage dynamique, l'équilibrage de charge et la politique CORS multi-origine pour l'ensemble des services backend.

- Technologies : Spring Boot 2.4.5, Spring Cloud Gateway 2.4.5, Spring Cloud Netflix Eureka Client

- Port d'écoute : 8080

- Intégrations : Service Config centralisé, Service Discovery Eureka, tous les microservices backend

- Sécurité : Gestion CORS avancée avec délégation de l'authentification aux services sous-jacents

- Routes exposées : 4 routes principales avec load balancing automatique (

/articles/**,/storage/**,/config/**,/eureka/**) - Le Dépôt du projet : Projet Github: ms-gateway

Configuration principale - bootstrap.yml

########## Localisation du fichier de configuration

# exemple : http://localhost:8089/gateway/dev

spring:

application:

name: gateway

cloud:

config:

uri: ${SERVICE_CONFIG_DOCKER:http://ms-configuration:8089}

label: main # Branche Git par défaut

gateway:

globalcors:

add-to-simple-url-handler-mapping: true

corsConfigurations:

"[/**]":

allowedOrigins:

- "https://blog-pre.ghoverblog.ovh"

- "https://blog-nas.ghoverblog.ovh"

- "https://ghoverblog.ovh"

- "http://192.168.1.98:4200"

allowedMethods:

- GET

- POST

- PUT

- PATCH

- DELETE

- OPTIONS

allowedHeaders:

- "*"

allowCredentials: true

exposedHeaders: # Ajout des en-têtes exposés

- "Access-Control-Allow-Origin"

- "Access-Control-Allow-Methods"

- "Access-Control-Allow-Headers"

- "Access-Control-Allow-Credentials"

maxAge: 3600 # Durée de cache pour les requêtes preflight

default-filters: # Désactive les doubles dans les en-têtes CORS

- DedupeResponseHeader=Access-Control-Allow-Origin Access-Control-Allow-Credentials

- AddResponseHeader=Access-Control-Allow-Origin, https://ghoverblog.ovh

- AddResponseHeader=Access-Control-Allow-Methods, GET,POST,PUT,DELETE,PATCH,OPTIONS

- AddResponseHeader=Access-Control-Allow-Headers, *

- AddResponseHeader=Access-Control-Allow-Credentials, true

filters:

- CustomPostFilter

Analyse de la configuration CORS

Stratégie multi-environnement :

Cette configuration supporte plusieurs environnements simultanément :

- Production :

https://ghoverblog.ovh - Pre-production :

https://blog-pre.ghoverblog.ovh,https://blog-nas.ghoverblog.ovh - Développement local :

http://localhost:4200,http://localhost:1080 - Réseau local :

http://192.168.1.98:4200

Gestion des doublons CORS :

Le filtre DedupeResponseHeader est crucial pour éviter les doublons d'en-têtes CORS qui peuvent causer des erreurs dans les navigateurs, particulièrement quand les microservices sous-jacents ajoutent également leurs propres en-têtes CORS.

Architecture des filtres - ConfigFilter.java

@Slf4j

@Configuration

public class ConfigFilter {

@Bean

public GlobalFilter preGlobalFilter() {

return (exchange, chain) -> {

log.info("**************");

log.info("Global Pre Filter executed ...");

log.info("Request Method : {}", exchange.getRequest().getMethod());

log.info("Request Origin : {}", exchange.getRequest().getHeaders().getOrigin());

log.info("Request Headers : {}", exchange.getRequest().getHeaders());

log.info("Response Status : {}", exchange.getResponse().getStatusCode());

log.info("**************");

return chain.filter(exchange);

};

}

@Bean

public GlobalFilter postGlobalFilter() {

return (exchange, chain) -> {

return chain.filter(exchange)

.then(Mono.fromRunnable(() -> {

log.info("**************");

log.info("Global post Filter chaine executed ...");

ServerHttpRequest serverHttpRequest = exchange.getRequest();

ServerHttpResponse serverHttpResponse = exchange.getResponse();

log.info("Request ----------------");

serverHttpRequest.getHeaders().forEach((key, value) -> {

log.info("Request Header: {} = {}", key, value);

});

log.info("Request Methode : {}", serverHttpRequest.getMethod());

log.info("Get Request Origine : {} ", exchange.getRequest().getHeaders().getOrigin());

log.info("Response ----------------");

serverHttpResponse.getHeaders().forEach((key, value) -> {

log.info("Response Header: {} = {}", key, value);

});

log.info("Response Status : {}", exchange.getResponse().getStatusCode());

}));

};

}

}

Avantages de cette approche de filtrage

1. Observabilité complète :

- Pre-filter : Capture toutes les requêtes entrantes avec leurs métadonnées

- Post-filter : Enregistre les réponses complètes après traitement

- Traçabilité : Permet de suivre le cycle complet d'une requête

2. Debugging facilité :

- Headers complets en entrée et sortie

- Méthodes HTTP et origins trackées

- Status codes de réponse loggés

3. Monitoring proactif :

- Détection des problèmes CORS en temps réel

- Analyse des patterns de trafic

- Identification des sources de requêtes

CustomPostFilter - Vérification post-DedupeResponseHeader

@Slf4j

@Component

public class CustomPostFilter implements GlobalFilter, Ordered {

@Override

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

return chain.filter(exchange)

.then(Mono.fromRunnable(() -> {

log.info("**************");

log.info("Custom Post Filter execute après le filtre DedupeResponseHeader");

exchange.getResponse().getHeaders().forEach((key, value) -> {

log.info("Response Header: {} = {}", key, value);

});

log.info("**************");

}));

}

@Override

public int getOrder() {

return Ordered.HIGHEST_PRECEDENCE; // Ensure this filter runs early

}

}

Rôle spécialisé du CustomPostFilter

Contrôle qualité des headers CORS :

Ce filtre joue un rôle crucial dans la validation de la configuration CORS en s'exécutant après le filtre DedupeResponseHeader. Il permet de :

- Vérifier l'efficacité du filtre de déduplication

- S'assurer qu'aucun doublon CORS n'atteint le client

- Logger l'état final des headers avant envoi au frontend

- Déboguer les problèmes de configuration CORS en production

Ordre d'exécution des filtres :

1. PreGlobalFilter (requête entrante)

2. DedupeResponseHeader (suppression des doublons)

3. CustomPostFilter (vérification post-déduplication)

4. PostGlobalFilter (logging final)

Architecture de sécurité déléguée

Principe de délégation

Contrairement à une approche centralisée où la Gateway gère l'authentification/autorisation, cette architecture délègue la sécurité aux microservices sous-jacents :

Avantages de cette approche :

- Granularité fine : Chaque service peut implémenter ses propres règles de sécurité

- Flexibilité : Services différents peuvent utiliser des mécanismes d'auth différents

- Isolation : Une faille dans un service n'expose pas tous les autres

- Evolution indépendante : Mise à jour des politiques de sécurité service par service

Architecture des Microservices

Service Configuration - Spring Cloud Config

Responsabilité : Serveur de configuration centralisée pour l'ensemble de l'écosystème microservices, fournissant une gestion externalisée des propriétés applicatives depuis un dépôt Git distant.

- Technologies : Spring Boot 2.4.5, Spring Cloud Config Server

- Port d'écoute : 8089

- Source de configuration : Les sources sont placées dans un dépôt privé.

- Pattern de recherche :

*service(tous les services) - Sécurité : Authentification SSH avec clé privée EC

- Le Dépôt du projet : Dépôt Github: ms-configuration

Configuration principale :

server:

port: 8089

spring:

application:

name: config-service

cloud:

config:

discovery:

enabled: false

server:

git:

uri: git@github.com:MGNetworking/properties-file-blog.git

search-Paths: "*service"

default-label: main

ignoreLocalSshSettings: true

privateKey: |

-----BEGIN EC PRIVATE KEY-----

xxxxxxxxx==

-----END EC PRIVATE KEY-----

Classe principale :

@SpringBootApplication

@EnableConfigServer

public class ConfigurationApplication {

public static void main(String[] args) {

SpringApplication.run(ConfigurationApplication.class, args);

}

}

Spécificités techniques :

- Discovery désactivé : Le service Config démarre indépendamment d'Eureka pour éviter les dépendances circulaires

- Authentification SSH : Utilisation d'une clé privée EC pour accéder au dépôt Git privé

- Monitoring : Endpoint

/actuator/healthexposé avec détails complets pour supervision - Pattern de fichiers : Recherche dans tous les répertoires se terminant par

servicepour organiser les configurations par microservice

Service Eureka Discovery - Spring Cloud Netflix Eureka

Responsabilité : Service de découverte et registre central pour référencer tous les microservices du projet. Cette liste est utilisée par le microservice Gateway pour la gestion du routage et la répartition des requêtes.

- Technologies : Spring Boot 2.4.5, Spring Cloud Netflix Eureka Server

- Configuration centralisée : Récupère sa configuration depuis le service Config Server

- Intégrations : Service Config Server via

ms-configuration:8089 - Le Dépôt du projet : Dépôt Github: ms-eureka

Configuration bootstrap :

spring:

application:

name: eureka

cloud:

config:

uri:

- ${SERVICE_CONFIG_DOCKER:http://ms-configuration:8089}

label: main

Classe principale :

@SpringBootApplication

@EnableEurekaServer

public class EurekaDiscoveryApplication {

// extends SpringBootServletInitializer

public static void main(String[] args) {

SpringApplication.run(EurekaDiscoveryApplication.class, args);

}

}

Spécificités techniques :

- Service Registry : Point central d'enregistrement pour tous les microservices

- Configuration externalisée : Utilise le Config Server pour récupérer ses propriétés

- Scripts de développement :

run.shetdown.shpour faciliter l'exécution en environnement DEV - Intégration Gateway : Fournit la liste des services disponibles pour le load balancing

- Le Dépôt du projet : Dépôt Github: ms-storage

Service Storage - Gestion des fichiers images

Responsabilité : API de sauvegarde des fichiers images sur le système hôte, créée avec les technologies Spring et les standards RESTful pour la gestion complète du stockage et de la récupération des images.

- Technologies : Spring Boot 2.5.3, Spring MVC

- Port d'écoute : 9011

- Context Path :

/STORE-SERVICE - APIs exposées :

GET /all-image- Récupération de toutes les imagesGET /download/{image-Name:.+}- Téléchargement d'image par nomPOST /upload-image- Upload d'une image uniquePOST /upload-multiple-image- Upload d'images multiplesDELETE /DeleteImg/{filename}- Suppression d'image

Configuration principale :

spring.application.name=STORE-SERVICE

server.servlet.context-path=/STORE-SERVICE

server.port=9011

# Multipar config

spring.servlet.multipart.enabled=true

spring.servlet.multipart.max-file-size=200MB

spring.servlet.multipart.max-request-size=200MB

spring.servlet.multipart.resolve-lazily=false

# Storage config

storage-article.location=./images

storage-article.url=images.ghoverblog.ovh

storage-article.pathblog=blog

Configuration CORS :

Contrairement aux autres microservices qui bénéficient de la gestion CORS centralisée au niveau du Spring Cloud Gateway, le service Storage fonctionne en accès direct et gère donc sa propre configuration CORS. Cette approche permet un accès optimisé pour les opérations de téléchargement/upload d'images sans passer par le load balancer.

@Slf4j

@Configuration

public class CorsConfig implements WebMvcConfigurer {

@Override

public void addCorsMappings(CorsRegistry registry) {

log.info("CorsConfig : {}", registry.toString());

registry.addMapping("/**")

.allowedOriginPatterns("*")

.allowedMethods("GET", "POST", "PUT", "DELETE", "OPTIONS")

.allowedHeaders("*")

.allowCredentials(true)

.maxAge(3600);

}

}

Spécificités techniques :

- Génération d'identifiants uniques : Algorithme SHA-256 pour créer des noms d'images uniques avec préfixe

IMG_ - Upload massif : Support du téléversement de fichiers multiples avec limitation à 200MB par fichier

- Stockage sécurisé : Association volume Docker entre chemin hôte et conteneur (

./imagesvers/app/images) - Gestion multi-environnement : Support développement local avec variable

HOST_PATH_IMGet déploiement conteneurisé - Logging avancé : Configuration Logback avec rotation des fichiers (10MB max, 7 jours de rétention)

- Scripts de développement :

run-dev.shpour compilation Maven et packaging Docker en phases distinctes

Architecture du service principal - FileSystemStorageService

La classe FileSystemStorageService constitue le cœur fonctionnel du service Storage, implémentant l'interface StorageService pour la gestion complète du cycle de vie des fichiers images sur le système de fichiers.

Initialisation automatique du service :

@Override

@PostConstruct

public void init() {

try {

Files.createDirectories(this.rootLocation);

log.info("Directories : {} is create ", this.rootLocation);

} catch (IOException e) {

log.error("Could not initialize storage location {}", String.valueOf(e.getCause()));

throw new StorageException("Could not initialize storage location ", e);

}

}

Création automatique du répertoire de stockage défini par this.rootLocation au démarrage de l'application grâce à l'annotation @PostConstruct.

Upload et traitement d'images :

@Override

public List<String> store(MultipartFile file) throws StorageException {

try (InputStream inputStream = file.getInputStream()) {

// generate image name

String nameFile = this.imageIdGenerator(file);

Path fileNamePath = this.rootLocation.resolve(nameFile);

Files.copy(inputStream, fileNamePath, StandardCopyOption.REPLACE_EXISTING);

log.info("The files is copied in : {}", fileNamePath);

return this.imageIpGenerator(nameFile, this.storageProperties.getPathblog());

} catch (StorageException | NoSuchAlgorithmException | IOException ex) {

log.error("Failed to store file: {}", ex.getMessage());

throw new StorageException("Failed to store file: " + ex.getMessage());

}

}

Processus : génération d'identifiant unique → copie sécurisée → retour du nom généré + URL d'accès complète.

Génération d'identifiants uniques :

public String imageIdGenerator(MultipartFile file) throws StorageException, NoSuchAlgorithmException {

String filename = StringUtils.cleanPath(file.getOriginalFilename());

// Use of the SHA-256 hash algorithm to generate a unique identifier

MessageDigest digest = MessageDigest.getInstance("SHA-256");

byte[] hashBytes = digest.digest(filename.getBytes());

// get Extension file

String extension = filename.substring(filename.lastIndexOf("."));

// Base64 encoding to obtain a character string

String ipAdresse = Base64.getEncoder().encodeToString(hashBytes) + extension;

// Replace invalid characters in the file name

String sanitizedFilename = ipAdresse.replaceAll("/", "").replaceAll("=", "");

sanitizedFilename = "IMG_" + sanitizedFilename;

return sanitizedFilename;

}

Processus : nettoyage du nom → hash SHA-256 → encodage Base64 → sanitisation → préfixe IMG_.

Construction d'URLs d'accès :

private List<String> imageIpGenerator(String name, String pathUri) {

List<String> lst = new ArrayList<String>();

lst.add(name);

lst.add(UriComponentsBuilder

.newInstance()

.scheme("https")

.host(this.storageProperties.getUrl())

.path(pathUri)

.path("/")

.path(name).build().toString());

return lst;

}

Génération d'URL complète au format https://{storage.url}/{pathblog}/{filename} avec support multi-environnement.

Récupération et suppression :

@Override

public List<String> loadAllUrls() throws StorageException {

try (Stream<Path> stream = Files.walk(this.rootLocation, 1)) {

return stream

.filter(path -> !path.equals(this.rootLocation))

.map(this::convertToUrl)

.collect(Collectors.toList());

} catch (IOException ex) {

throw new StorageException("Failed to read stored files", ex);

}

}

@Override

public boolean deleteImg(String fileName) {

Path filePath = Paths.get(this.rootLocation.toString(), fileName);

if (Files.exists(filePath)) {

try {

Files.delete(filePath);

return !Files.exists(filePath);

} catch (IOException ex) {

throw new StorageException("Delete operation failed: " + ex.getMessage());

}

}

return false;

}

Utilisation de la Stream API pour le listing efficace et suppression atomique avec vérification d'existence.

Service Article - Gestion métier et publication de contenu

Responsabilité : Cœur métier de la plateforme de publication, gérant l'intégralité du cycle de vie des articles depuis la création jusqu'à la publication, avec une architecture sécurisée basée sur Keycloak et une gestion fine des autorisations utilisateur.

- Technologies : Spring Boot 2.4.5, Spring Data JPA, Spring Security, Keycloak Adapter 20.0.3

- Base de données : PostgreSQL 42.5.2 avec schéma dédié

ms_article - Intégrations : Service Config centralisé, Service Discovery Eureka, Service Storage

- Sécurité : Authentification Keycloak avec gestion granulaire des autorisations

- APIs exposées : 12 endpoints RESTful avec validation Bean Validation et documentation OpenAPI

- Le Dépôt du projet : Dépôt Github: ms-article

Architecture de sécurité avec Keycloak

Le service Article implémente une architecture de sécurité déléguée où l'authentification est centralisée via Keycloak tandis que l'autorisation est gérée localement pour une granularité maximale.

Configuration de sécurité HTTP - KeycloakSecurityService :

La classe KeycloakSecurityService étend KeycloakWebSecurityConfigurerAdapter pour intégrer seamlessly Keycloak avec Spring Security :

@KeycloakConfiguration

@EnableGlobalMethodSecurity(prePostEnabled = true)

public class KeycloakSecurityService extends KeycloakWebSecurityConfigurerAdapter {

@Override

protected void configure(HttpSecurity http) throws Exception {

super.configure(http);

http.cors().disable()

.csrf().disable()

.authorizeRequests()

.antMatchers(HttpMethod.OPTIONS, "/**").permitAll()

.antMatchers("/articles/getAllArticles",

"/articles/getAllArticlesSection",

"/articles/getAllDomain")

.permitAll()

.antMatchers("/articles/saveArticle")

.hasAuthority("user")

.antMatchers("/articles/updateArticle",

"/articles/deleteArticle/*",

"/articles/update/**")

.hasAnyAuthority("admin", "user");

}

}

Stratégie de gestion CORS déléguée :

Contrairement aux autres microservices, le service Article désactive volontairement CORS car la gestion multi-origine est centralisée au niveau du Spring Cloud Gateway. Cette approche évite les conflits d'en-têtes et optimise les performances.

Système d'autorisation granulaire - Classe Access :

La classe Access implémente une logique d'autorisation sophistiquée qui combine ownership et role-based access control :

@Component

public class Access {

public boolean isAuthorization(String userId) {

SecurityContext securityContext = SecurityContextHolder.getContext();

Authentication authentication = securityContext.getAuthentication();

// Vérification ownership : l'utilisateur est-il le créateur ?

if (userId.equals(this.getUserIdFromToken(authentication))) {

return true;

}

// Vérification role : l'utilisateur a-t-il le rôle admin ?

if (this.hasRole(authentication, "admin")) {

return true;

}

return false;

}

}

Multi-provider token support :

Le système supporte deux types de tokens Keycloak :

- JWT tokens : Extraction via

jwt.getClaimAsString("sub") - Keycloak Principal : Extraction via

kcPrincipal.getName()

Cette flexibilité permet de supporter différents modes d'authentification selon l'environnement de déploiement.

Modèle de données et relations JPA

L'architecture de données suit un pattern Domain-Driven Design avec une hiérarchie claire : Domain → Section → Article.

Entité Article - Cœur du modèle métier :

@Entity

@Table(name = "article", schema = "ms_article")

@Cacheable(false) // Désactive le cache L2 pour éviter les problèmes de cohérence

public class Article implements Serializable {

@Id

@GeneratedValue(strategy = GenerationType.IDENTITY)

@Column(name = "id_article")

private Integer idArticle;

@ManyToOne(fetch = FetchType.LAZY)

@JoinColumn(name = "id_section", referencedColumnName = "id_section")

private Section section;

@Lob

@Type(type = "org.hibernate.type.TextType")

@Column(name = "article", nullable = false)

private String article;

@CreationTimestamp

private Timestamp dateCreation;

}

Optimisations de performance :

- Lazy Loading : La relation

@ManyToOne(fetch = FetchType.LAZY)avec Section évite le N+1 problem - Désactivation du cache L2 :

@Cacheable(false)pour éviter les incohérences dans un environnement multi-instances - Types LOB optimisés : Utilisation de

TextTypepour le stockage efficace du contenu HTML

Relations hiérarchiques :

// Domain (1) -> Section (N) -> Article (N)

@Entity

public class Domain {

@OneToMany(fetch = FetchType.EAGER)

@JoinColumn(name="id_domain")

private Collection<Section> sections = new ArrayList<>();

}

Le choix du FetchType.EAGER pour Domain→Section est justifié car cette relation est toujours utilisée dans son intégralité (navigation, filtres de recherche).

Couche service et logique métier

ArticleServiceImpl - Architecture transactionnelle :

La classe ArticleServiceImpl implémente une architecture transactionnelle robuste avec gestion fine des exceptions métier :

@Service

@Transactional(rollbackFor = Exception.class)

public class ArticleServiceImpl implements ArticleService {

@Override

public Page<ArticleDto> findAllArticleWithVisiblityPageOrderBy(

boolean visibility, boolean portfolio, Pageable pageable) {

try {

Page<Article> articleData = this.articleRepository

.findAllPortfolioArticlesByVisibility(visibility, portfolio, pageable);

// Initialisation explicite des relations Lazy

articleData.getContent().forEach(

art -> Hibernate.initialize(art.getSection()));

return articleData.map(article ->

this.modelMapper.map(article, ArticleDto.class));

} catch (DataAccessException ex) {

throw new ArticleException(

String.format("Erreur lors de la récupération : %s", ex.getMessage()),

HttpStatus.INTERNAL_SERVER_ERROR);

}

}

}

Gestion proactive du Lazy Loading :

L'utilisation de Hibernate.initialize(art.getSection()) évite les LazyInitializationException en forçant le chargement des relations avant la transformation en DTO.

Pattern de mise à jour optimisé :

Le service implémente trois stratégies de mise à jour selon le besoin :

- Mise à jour complète :

updateArticle()- Rechargement complet de l'entité - Mise à jour des champs :

updateArticleFields()- Query JPQL ciblée - Mise à jour des métadonnées :

updateArticleMeta()- Query JPQL pour les flags

// Exemple de mise à jour optimisée via JPQL

@Modifying

@Query("UPDATE Article a SET " +

"a.titre = CASE WHEN :#{#dto.titre} IS NULL THEN a.titre ELSE :#{#dto.titre} END, " +

"a.dateMaj = CURRENT_TIMESTAMP " +

"WHERE a.idUser = :#{#dto.idUser} AND a.idArticle = :#{#dto.idArticle}")

int updateArticleFields(@Param("dto") ArticleDto dto);

Cette approche évite le pattern "select-then-update" pour les modifications partielles, réduisant significativement les accès base de données.

API REST et endpoints

ControllerArticle - Architecture RESTful complète :

Le contrôleur expose 12 endpoints suivant les conventions REST avec validation Bean Validation intégrée :

Endpoints publics (sans authentification) :

GET /articles/{id}- Consultation d'article individuelGET /articles/list- Pagination d'articlesGET /articles/sorted- Articles triés avec filtres visibility/portfolioGET /articles/section- Articles par sectionGET /articles/portfolio- Projections d'articles portfolioGET /articles/domain- Liste des domaines et sections

Endpoints sécurisés (authentification requise) :

POST /articles/save- Création d'article (rôleuser)PUT /articles/update- Mise à jour complète (rôlesadminouuser)PATCH /articles/update/fields- Mise à jour partielle des champsPATCH /articles/update/meta- Mise à jour des métadonnéesDELETE /articles/delete/{idArticle}/{idUser}- Suppression

Exemple de sécurisation avec @PreAuthorize :

@PostMapping("/save")

@PreAuthorize("@access.isAuthorization(#articleDtoSave.idUser)")

public ResponseEntity<GenericApiResponse<ArticleDto>> saveArticle(

@Valid @RequestBody ArticleDtoSave articleDtoSave,

HttpServletRequest request) {

return ResponseHandler.generateResponse(

"L'article à été créer avec succès",

HttpStatus.CREATED,

request.getRequestURI(),

this.articleService.saveArticle(articleDtoSave));

}

Validation Bean Validation avancée :

Les DTOs intègrent des validations métier sophistiquées :

public class ArticleDtoSave {

@NotBlank(message = "Vous devez mettre un titre")

@Size(min = 3, max = 100, message = "Le titre doit contenir entre 3 et 100 caractères.")

private String titre;

@NotBlank(message = "l'URL de l'image n'est pas présent")

@Pattern(regexp = "^https://.*$", message = "L'URL de l'image doit être une URL valide")

private String imgUrl;

}

Requêtes optimisées et projections

ArticleRepository - Requêtes JPQL performantes :

Le repository implémente des requêtes JPQL optimisées pour éviter les problèmes de performance :

@Query("SELECT art FROM Article art WHERE art.section.idSection = :section " +

"and art.portfolio = :ptfolio AND art.visibiliter = :visible " +

"ORDER BY art.idArticle asc")

Page<Article> findAllArticlesBySection(@Param("section") Integer section,

@Param("visible") boolean visible,

@Param("ptfolio") boolean portfolio,

Pageable pageable);

Projections dynamiques pour l'optimisation :

<T> Page<T> findByPortfolioTrueOrderByIdArticleAsc(Pageable pageable, Class<T> type);

Cette méthode utilise les Spring Data Projections pour retourner uniquement les champs nécessaires (titre, description, image) dans les vues portfolio, réduisant drastiquement le volume de données transférées.

Gestion d'erreurs et réponses standardisées

Pattern de réponse unifié - ResponseHandler :

Tous les endpoints utilisent le ResponseHandler pour standardiser le format des réponses API :

public static <T> ResponseEntity<GenericApiResponse<T>> generateResponse(

String message, HttpStatus status, String path, T responseObj) {

GenericApiResponse<T> response = GenericApiResponse.<T>builder()

.message(message)

.status(status)

.statusCode(status.value())

.path(path)

.data(responseObj)

.build();

return new ResponseEntity<>(response, status);

}

Gestion des exceptions métier :

La classe ArticleException étend RuntimeException avec support des codes HTTP pour une propagation fine des erreurs vers la couche présentation.

Spécificités techniques avancées

Sérialisation JSON personnalisée :

Le projet implémente des sérialiseurs/désérialiseurs personnalisés pour la gestion fine des dates :

@JsonSerialize(using = DateSerialisation.class)

@JsonDeserialize(using = DateDeserializer.class)

private Timestamp dateCreation;

Cette approche garantit un format de date uniforme (yyyy-MM-dd HH:mm:ss) indépendamment des configurations locales.

Configuration de tests stratifiés :

Le pom.xml configure trois niveaux de tests :

- Tests unitaires :

*Test.javaavec Surefire - Tests d'intégration :

*ITTest.javaavec Failsafe - Tests E2E :

*E2ETest.javaavec Failsafe

Cette stratification permet une exécution ciblée selon les besoins (développement vs CI/CD).

Intégration avec l'écosystème microservices :

Le service s'intègre seamlessly avec l'écosystème via :

- Config externalisée :

bootstrap.ymlpointe versms-configuration:8089 - Service Discovery : Enregistrement automatique auprès d'Eureka

- Monitoring : Endpoints Actuator pour health checks et métriques

- Documentation : Intégration SpringDoc OpenAPI pour documentation auto-générée

Cette architecture garantit une scalabilité horizontale et une maintenabilité optimale tout en préservant la sécurité et les performances dans un environnement microservices distribué.

Communication inter-services

L'architecture microservices de ce projet implémente une communication synchrone basée sur HTTP/HTTPS avec un système de découverte automatique via Eureka. Cette approche, spécifiquement conçue pour Docker Swarm, compense l'absence de service discovery natif dans cet orchestrateur en implémentant le Spring Cloud Netflix Stack.

Justification architecturale - Pourquoi Eureka avec Docker Swarm ?

Contraintes de l'orchestrateur Docker Swarm :

Contrairement à Kubernetes qui dispose de service discovery natif et de load balancing intégré, Docker Swarm ne fournit pas de registre de services dynamique permettant aux microservices de se découvrir automatiquement. Cette limitation nécessite une solution applicative pour :

- Service Registry : Catalogue central des services disponibles

- Service Discovery : Résolution dynamique des noms de services

- Health Monitoring : Surveillance de l'état des instances

- Load Balancing : Distribution intelligente des requêtes

Solution Spring Cloud Netflix adoptée :

// Pattern de découverte automatique

@EnableEurekaServer // Service Eureka - Registre central

@EnableEurekaClient // Services clients - Auto-enregistrement

@EnableZuulProxy // Gateway - Load balancing intelligent

Cette approche recrée les fonctionnalités manquantes de Docker Swarm via des composants Spring Cloud.

Architecture de communication centralisée

Pattern de communication observé :

Communication Frontend → Services via Gateway :

Le frontend Angular communique exclusivement avec le Spring Cloud Gateway, qui route intelligemment vers les services appropriés :

// Dans Angular - Toutes les requêtes passent par la Gateway

@Injectable({

providedIn: "root",

})

export class ArticleService {

private readonly API_ARTICLE: string =

environment.articleApi + "/MS-ARTICLE/"; // Gateway URL

saveArticle(article: Article): Observable<ResponseApi<Article>> {

const header = new HttpHeaders({

"Content-Type": "application/json",

});

const url = `${this.API_ARTICLE}articles/save`;

return this.http.post<ResponseApi<Article>>(url, article).pipe(

map((responseApi: ResponseApi<Article>) => {

console.log("Response Api " + responseApi);

this.articleSubject.next({ ...article });

return responseApi;

})

);

}

}

Sauf pour le service Storage qui lui est autonome

@Injectable({

providedIn: 'root',

})

export class ImagesService {

private readonly API_URL: string = environment.imagesApi + '/STORE-SERVICE/';

saveImage(blob: Blob | string): Observable<any> {

// En-tête de requête

const headers = new HttpHeaders();

headers.append('Accept', 'application/json');

// Créer un objet FormData et y ajouter le fichier

let formatDate = new FormData();

formatDate.append('image', blob);

let img: Images;

return this.http

.post<any>(this.API_URL + `upload-image`, formatDate, {

headers,

})

.pipe(

take(1), // se désabonne automatiquement après avoir émis une seule valeur

map((response: Images) => {

const img: Images = {

name: response.name,

uri: response.uri,

};

return img;

}),

catchError((error) => this.error.handlerError(error))

);

}

Service Storage - Accès direct pour optimisation :

Le Service Storage, gérant les fichiers statiques, expose également un accès direct pour optimiser les performances des téléchargements :

// Configuration CORS spécifique pour accès direct

@Configuration

public class CorsConfig implements WebMvcConfigurer {

@Override

public void addCorsMappings(CorsRegistry registry) {

registry.addMapping("/**")

.allowedOriginPatterns("*")

.allowedMethods("GET", "POST", "PUT", "DELETE", "OPTIONS")

.allowedHeaders("*")

.allowCredentials(true);

}

}

Cette double approche (Gateway + accès direct) permet de :

- Router les APIs métier via la Gateway pour centralisation et sécurité

- Optimiser les téléchargements via accès direct pour performances

Service Discovery - Eureka comme registre central

Eureka Server - Cœur du service discovery :

@SpringBootApplication

@EnableEurekaServer

public class EurekaDiscoveryApplication {

public static void main(String[] args) {

SpringApplication.run(EurekaDiscoveryApplication.class, args);

}

}

Configuration Eureka Server :

eureka:

instance:

hostname: ms-eureka

client:

registerWithEureka: false # Le serveur ne s'enregistre pas

fetchRegistry: false # Le serveur ne récupère pas le registre

serviceUrl:

defaultZone: http://ms-eureka:8761/eureka/

server:

waitTimeInMsWhenSyncEmpty: 0

enableSelfPreservation: false

Auto-enregistrement des services clients :

Chaque microservice s'enregistre automatiquement au démarrage :

# bootstrap.yml - Configuration commune à tous les services

spring:

application:

name: ms-article # Identifiant unique dans le registre

cloud:

config:

uri: ${SERVICE_CONFIG_DOCKER:http://ms-configuration:8089}

label: main

eureka:

client:

serviceUrl:

defaultZone: http://ms-eureka:8761/eureka/

instance:

preferIpAddress: true

instanceId: ${spring.application.name}:${random.int}

Spring Cloud Gateway - Consumer intelligent du registre :

La Gateway utilise Eureka pour découvrir les services et configurer le routage automatiquement :

spring:

cloud:

gateway:

discovery:

locator:

enabled: true # Active la découverte automatique

lowerCaseServiceId: true

routes:

- id: article-service

uri: lb://ms-article # Load balancer via Eureka

predicates:

- Path=/articles/**

- id: storage-service

uri: lb://ms-storage

predicates:

- Path=/storage/**

- id: config-service

uri: lb://ms-configuration

predicates:

- Path=/config/**

Le préfixe lb:// active le client-side load balancing avec résolution automatique via Eureka.

Workflow complet de découverte des services

Séquence de démarrage et découverte :

1. ms-configuration démarre → S'enregistre auprès d'Eureka

2. ms-article démarre → Récupère config depuis Config Server → S'enregistre auprès d'Eureka

3. ms-storage démarre → Récupère config depuis Config Server → S'enregistre auprès d'Eureka

4. gateway démarre → Récupère la liste des services depuis Eureka → Configure routes

5. Frontend Angular → Toutes requêtes via Gateway → Routage intelligent vers services

Monitoring et Health Checks automatiques :

// Health indicator personnalisé dans chaque service

@Component

public class ServiceHealthIndicator implements HealthIndicator {

@Override

public Health health() {

// Vérifications métier spécifiques

if (isDatabaseConnected() && isConfigurationLoaded()) {

return Health.up()

.withDetail("service", "ms-article")

.withDetail("version", "1.0.0")

.build();

}

return Health.down()

.withDetail("error", "Service indisponible")

.build();

}

}

Avantages de cette architecture pour Docker Swarm

1. Comble les lacunes de Docker Swarm :

- Service Discovery manquant : Eureka fournit un registre centralisé

- Load Balancing applicatif : Distribution intelligente des requêtes

- Health Checks avancés : Surveillance métier vs simple ping réseau

- Configuration centralisée : Spring Config Server vs variables d'environnement

2. Flexibilité et résilience :

- Scaling horizontal dynamique : Nouvelles instances détectées automatiquement

- Failover automatique : Services défaillants retirés du registre

- Zero-downtime deployments : Déploiement progressif sans interruption

- Multi-environment : Même code pour dev/staging/prod

3. Observabilité et debugging :

- Console Eureka : Visualisation en temps réel de l'état des services

- Métriques intégrées : Via Spring Boot Actuator

- Logging centralisé : Traçage des communications inter-services

Cette architecture Spring Cloud Netflix constitue la solution optimale pour un écosystème microservices sur Docker Swarm, compensant efficacement les limitations de l'orchestrateur tout en fournissant une expérience développeur équivalente à des solutions plus complexes comme Kubernetes.

Infrastructure et Conteneurisation

Docker & Docker Compose - Architecture multi-environnement

L'infrastructure de ce projet adopte une stratégie de conteneurisation sophistiquée avec Docker, optimisée pour un workflow DevOps complet allant du développement local jusqu'à la production sur Docker Swarm.

Avantages de la conteneurisation adoptée :

- Portabilité multi-environnement : Configuration adaptative (dev, staging, prod)

- Isolation des dépendances : JDK, outils systèmes, scripts encapsulés

- Déploiement zero-downtime : Stratégies de rolling update avec rollback automatique

- Observabilité intégrée : Health checks métier et monitoring des ressources

- Sécurité renforcée : Gestion des droits utilisateur et isolation réseau

Architecture Docker multi-stage

Dockerfile optimisé - Service Article :

# Image de base légère pour l'exécution

FROM openjdk:8-jdk-alpine

# Installation des outils système nécessaires pour les scripts de santé

RUN apk --no-cache add curl jq

# Définition de la variable contenant le nom du script d'attente

ENV WAIT_SCRIPT=wait_for_config.sh

# Configuration du workspace

WORKDIR /app

COPY target/*.jar /app/app.jar

# Copie des scripts de gestion et de monitoring

COPY script/${WAIT_SCRIPT} /app

COPY ./script/healthcheck.sh /app

# Configuration des permissions et logging

RUN mkdir /app/logs \

&& touch /app/logs/healthcheck.log \

&& chmod +x /app/*.sh

EXPOSE 9010

ENTRYPOINT ["sh", "-c","sh /app/${WAIT_SCRIPT}"]

Spécificités techniques de cette approche :

- Image Alpine : Réduction de 70% de la taille (150MB vs 500MB standard)

- Outils intégrés :

curletjqpour health checks et communication inter-services - Scripts embarqués : Gestion de l'attente du Config Server et monitoring

- Logging préparé : Répertoire et fichiers de logs créés à l'initialisation

Stratégie multi-compose pour différents environnements

Docker Compose Build - Pipeline Jenkins

version: "3.9"

services:

ms-article:

container_name: ms-article

restart: always

image: sonatype-nexus.backhole.ovh/ms-article-service:${IMAGE_VERSION:-latest}

env_file:

- .env

build:

context: .

dockerfile: Dockerfile

ports:

- "${PORT}:9010"

Usage : Ce compose est utilisé exclusivement pour la phase de build dans la pipeline Jenkins, permettant la construction et le test de l'image avant push vers Nexus.

Docker Compose Swarm - Production

version: "3.9"

services:

ms-article:

image: sonatype-nexus.backhole.ovh/ms-article-service:${IMAGE_VERSION:-latest}

user: "${USER_ID}:${GROUP_ID}" # Héritage des droits utilisateur host

volumes:

- ./logs:/app/logs:rw

env_file:

- .env

environment:

PROFILE_ACTIF_SPRING: ${PROFILES}

SERVICE_CONFIG_DOCKER: ${SERVICE_CONFIG_URI:-http://ms-configuration:8089}

deploy:

replicas: 1

labels:

- "lb.service=ms-article-service"

update_config:

parallelism: 1 # Mise à jour séquentielle

delay: 30s # Délai entre mises à jour

order: start-first # Démarrage avant arrêt de l'ancienne version

failure_action: rollback # Rollback automatique en cas d'échec

monitor: 30s # Période de monitoring post-déploiement

max_failure_ratio: 0.3 # Seuil d'échec avant rollback

rollback_config:

parallelism: 1

delay: 30s

order: start-first

failure_action: continue

monitor: 30s

max_failure_ratio: 0.3

healthcheck:

test: ["CMD-SHELL", "/app/healthcheck.sh"]

interval: 15s # Vérification toutes les 15s

timeout: 15s # Timeout des health checks

retries: 3 # 3 échecs avant marquage "unhealthy"

start_period: 60s # Période de grâce au démarrage

ports:

- "${PORT}:9010"

networks:

- api

networks:

api:

external: true

name: spring-api

Gestion avancée des déploiements - Script deploy.sh

Script de déploiement multi-environnement :

#!/bin/bash

BUILD=$1 # beta/release

PROFILES=$2 # nas/prod

echo "Exportation des variables depuis .env"

export $(cat .env)

export PROFILES

# Chargement des variables utilisateur système

if [ -f ~/.profile ]; then

source ~/.profile

echo "✅ Fichier ~/.profile chargé avec succès."

fi

# Gestion des droits Unix pour volumes partagés

echo "Configuration des droits utilisateur host"

USER_ID=$(id -u)

GROUP_ID=$(id -g)

export USER_ID GROUP_ID

# Préparation du système de fichiers

LOGS_DIR="$(pwd)/logs"

if [ ! -d "$LOGS_DIR" ]; then

mkdir -p "$LOGS_DIR"

chmod -R 760 "$LOGS_DIR"

chown -R ${USER_ID}:${GROUP_ID} "$LOGS_DIR"

echo "✅ Dossier logs créé et configuré"

fi

# Construction du tag de version final

BUILD=${BUILD:-release}

export IMAGE_VERSION="${IMAGE_VERSION}-${BUILD}"

echo "🚀 Déploiement stack=$STACK_NAME version=$IMAGE_VERSION profile=$PROFILES"

docker stack deploy -c ./docker-compose-swarm.yml $STACK_NAME

Points techniques avancés :

- Gestion des droits Unix :

USER_ID:GROUP_IDpour éviter les problèmes de permissions sur volumes - Variables environnement cascadées :

.env→~/.profile→ variables pipeline - Versioning dynamique : Construction du tag final

${VERSION}-${BUILD} - Préparation filesystem : Création automatique et sécurisation du dossier logs

Orchestration intelligente - Script wait_for_config.sh

Gestion des dépendances de démarrage :

#!/bin/bash

echo "Initialisation du service ms-article"

echo "PROFILE_ACTIF_SPRING=$PROFILE_ACTIF_SPRING"

echo "SERVICE_CONFIG_DOCKER=$SERVICE_CONFIG_DOCKER"

# Mode développement local - démarrage direct

if [ "$PROFILE_ACTIF_SPRING" = "devDocker" ]; then

echo "Mode développement local activé"

exec java -jar app.jar --spring.profiles.active=$PROFILE_ACTIF_SPRING

else

# Mode production - attente du Config Server

while true; do

response=$(curl -s $SERVICE_CONFIG_DOCKER/actuator/health | jq -r '.status')

echo "Vérification Config Server: $SERVICE_CONFIG_DOCKER/actuator/health"

if [ "$response" == "UP" ]; then

echo "✅ Config Server opérationnel - Démarrage du service"

exec java -jar app.jar --spring.profiles.active=$PROFILE_ACTIF_SPRING

break

else

echo "⏳ Config Server non disponible - Nouvelle tentative dans 3s"

sleep 3

fi

done

fi

Architecture de démarrage intelligent :

- Mode devDocker : Démarrage immédiat sans dépendances (développement local)

- Mode production : Attente active du Config Server avec polling intelligent

- Logging détaillé : Variables d'environnement tracées pour debugging

- Resilience : Retry automatique avec backoff fixe

Stratégies Docker Swarm avancées

Configuration de résilience et performance

Update Strategy - Zero Downtime Deployments :

update_config:

parallelism: 1 # Une instance à la fois

delay: 30s # Délai de stabilisation

order: start-first # Blue-Green deployment pattern

failure_action: rollback # Rollback automatique

monitor: 30s # Monitoring post-déploiement

max_failure_ratio: 0.3 # 30% d'échec maximum toléré

Health Checks métier intégrés :

healthcheck:

test: ["CMD-SHELL", "/app/healthcheck.sh"]

interval: 15s # Surveillance continue

timeout: 15s # SLA de réponse

retries: 3 # Tolérance aux erreurs transitoires

start_period: 60s # Période de warm-up

Réseau et sécurité

Configuration réseau overlay :

networks:

api:

external: true # Réseau partagé entre stacks

name: spring-api # Namespace commun microservices

Avantages de cette approche :

- Isolation réseau : Trafic inter-services chiffré via overlay network

- Service Discovery automatique : Résolution DNS native Docker Swarm

- Load Balancing intégré : Distribution automatique des requêtes

- Segmentation sécurisée : Services accessibles uniquement via réseau overlay

Pipeline d'intégration continue complète

Workflow Jenkins intégré

Étapes clés de la containerisation :

Build Stage :

stage('Maven Compilation') { agent { docker { image 'maven:3.8.5-jdk-8-slim' args '-v /var/jenkins_home/maven/.m2:/root/.m2' } } }Docker Build :

stage('Build Docker Image') { steps { sh("docker compose build --no-cache") } }Registry Push :

stage('Tag / Push Docker Images') { steps { sh("docker tag ${env.IMAGE_NAME_BASE} ${dockers.img}") sh("docker push ${dockers.img}") } }Deployment :

stage('Update / Deploy') { steps { utilsDocker.deployStack( "cd ${dockers.pathProjet} && ./script/deploy.sh ${env.BUILD} ${env.BRANCH_NAME}", true, remote) } }

Registry Nexus intégration

Gestion centralisée des artefacts :

image: sonatype-nexus.backhole.ovh/ms-article-service:${IMAGE_VERSION}

Avantages :

- Registre privé sécurisé : Contrôle d'accès et authentification

- Versioning sophistiqué : Tags beta/release avec metadata

- Scan de vulnérabilités : Analyse automatique des images

- Politique de rétention : Gestion automatique de l'espace disque

Monitoring et observabilité conteneurisée

Health Checks multicouches

Script healthcheck.sh personnalisé :

#!/bin/bash

# Health check métier vs simple ping réseau

HEALTH_URL="http://localhost:9010/actuator/health"

response=$(curl -s $HEALTH_URL | jq -r '.status')

if [ "$response" == "UP" ]; then

echo "Service healthy" >> /app/logs/healthcheck.log

exit 0

else

echo "Service unhealthy: $response" >> /app/logs/healthcheck.log

exit 1

fi

Logging et persistence

Configuration des volumes :

volumes:

- ./logs:/app/logs:rw # Persistence des logs sur host

user: "${USER_ID}:${GROUP_ID}" # Droits utilisateur cohérents

Cette architecture garantit une haute disponibilité et une facilité de maintenance tout en optimisant les performances et la sécurité dans un environnement Docker Swarm distribué.

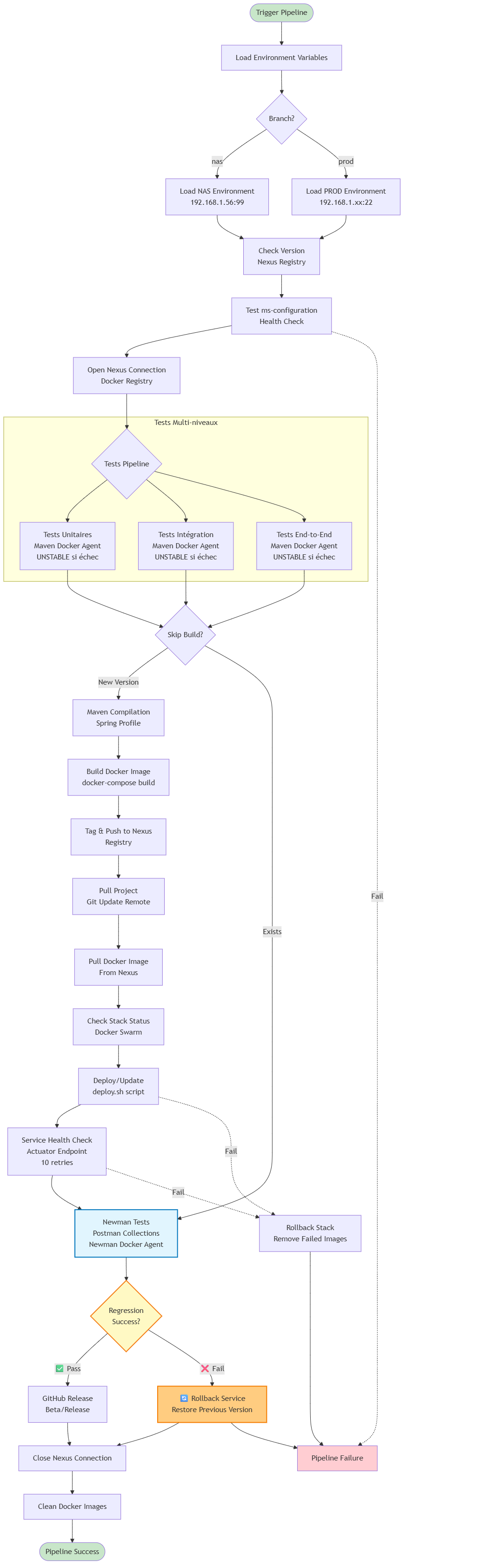

CI/CD avec Jenkins

Pipeline de déploiement automatisé

La pipeline CI/CD de ce projet implémente un workflow DevOps complet avec Jenkins, orchestrant l'intégralité du cycle de vie depuis les tests jusqu'au déploiement en production, avec une stratégie de tests multi-niveaux et une gestion avancée des artefacts.

Architecture de la pipeline :

Configuration multi-environnement et sécurité

Jenkinsfile - Gestion des environnements :

@Library('JenkinsLib_Shared') _

pipeline {

agent { label 'master' }

environment {

// Credentials sécurisés par environnement

Nas_CREDS = credentials('NAS')

Prod_CREDS = credentials('PROD')

Nexus_CREDS = credentials('nexus-credentials')

// Utilisateurs de test Keycloak

TEST_USER_ONE = credentials('keycloak-test-user-one')

TEST_USER_TWO = credentials('keycloak-test-user-two')

// API Keys externes

POSTMAN_API_KEY = credentials('postman-api-key')

COLLECTION_ID = credentials('MS_ARTICLE_COLLECTION_ID')

}

parameters {

booleanParam(name: 'VERSION', defaultValue: true,

description: 'Par défaut la version sera beta')

booleanParam(name: 'FORCE', defaultValue: false,

description: 'Forcer une compilation')

string(defaultValue: '', name: 'PUBLIC_MESSAGE',

description: 'Message de Publication GitHub')

}

}

Gestion dynamique des configurations par branche :

stage('Load Environment Variables : nas') {

when { expression { return env.BRANCH_NAME == 'nas' } }

steps {

script {

// Configuration serveur NAS (pré-production)

remote = utilsServeur.remote(

"${env.BRANCH_NAME}", // nas

'192.168.1.56', // IP NAS Synology

true, // allowAnyHosts

99, // Port SSH custom

Nas_CREDS_USR, // User

Nas_CREDS_PSW) // Password

dockers = utilsServeur.dockers(

env.IMAGE_NAME, // Image

'/volume1/docker/ms-article', // Path Synology

env.STACK_NAME) // Stack

}

}

}

Stratégie de versioning intelligente

Gestion automatique des versions et artefacts :

stage('Check version') {

steps {

script {

version_beta = "${env.IMAGE_VERSION}-beta"

version_release = "${env.IMAGE_VERSION}-release"

// Vérification existence dans Nexus Registry

def http_status_beta = sh(script: """

curl -s -o /dev/null -w "%{http_code}" -u ${nexus.user}:${nexus.pass} \

https://${nexus.domain}/repository/docker-private/v2/${env.PATH_NEXUS}/manifests/${version_beta}

""", returnStdout: true).trim()

if (http_status_beta.equals("404")) {

echo("✅ Version ${version_beta} disponible - Build autorisé")

env.SKIP_BUILD = true

} else {

echo("⚠️ Version ${env.IMAGE_TAG} existante - Tests uniquement")

env.SKIP_BUILD = false

}

}

}

}

Cette stratégie évite les builds inutiles et optimise les ressources CI/CD en ne construisant que les versions inexistantes.

Architecture de tests multi-niveaux

Tests Unitaires - Isolation complète

stage('UNITAIRE') {

agent {

docker {

image 'maven:3.8.5-jdk-8-slim'

args '-v /var/jenkins_home/maven/.m2:/root/.m2'

}

}

steps {

script {

catchError(buildResult: 'UNSTABLE', stageResult: 'FAILURE') {

sh """

mvn clean test -Dspring.profiles.active=test \\

-Dsurefire.reportsDirectory=target/unit-reports

"""

// Archivage et publication des résultats

archiveArtifacts artifacts: 'target/unit-reports/*.xml'

junit testResults: "target/unit-reports/*.xml",

allowEmptyResults: true

}

}

}

}

Tests d'Intégration - Base de données H2

stage('INTEGRATION') {

agent {

docker {

image 'maven:3.8.5-jdk-8-slim'

args '-v /var/jenkins_home/maven/.m2:/root/.m2'

}

}

steps {

script {

catchError(buildResult: 'UNSTABLE', stageResult: 'FAILURE') {

sh """

mvn verify -P integration -Dspring.profiles.active=test \\

-Dfailsafe.reportsDirectory=target/integration-reports

"""

junit testResults: "target/integration-reports/*.xml"

}

}

}

}

Tests End-to-End - Environnement complet

stage('END TO END') {

steps {

script {

profileTest = "test-${env.BRANCH_NAME}" // test-nas / test-prod

sh """

mvn verify -P e2e -Dspring.profiles.active=${profileTest} \\

-DSERVICE_CONFIG_DOCKER=http://192.168.1.56:8089 \\

-Dtest.keycloak.user.one=${TEST_USER_ONE_USR} \\

-Dtest.keycloak.password.one=${TEST_USER_ONE_PSW}

"""

}

}

}

Tests de Régression - Newman/Postman

stage('REGRESSION') {

agent {

docker {

image "sonatype-nexus.backhole.ovh/newman-devops:latest"

registryUrl "https://sonatype-nexus.backhole.ovh"

registryCredentialsId 'nexus-credentials'

}

}

steps {

script {

// Récupération collection Postman via API

def collectionUrl = "https://api.getpostman.com/collections/${COLLECTION_ID}?apikey=${POSTMAN_API_KEY}"

sh """

newman run "${collectionUrl}" \\

--environment=postman_files/environment.json \\

--reporters cli,junit,htmlextra \\

--reporter-junit-export=newman-reports/junit-report.xml \\

--reporter-htmlextra-export=newman-reports/report.html

"""

// Publication rapport HTML

publishHTML([

allowMissing: true,

reportDir: 'newman-reports',

reportFiles: 'report.html',

reportName: 'Newman HTML Report'

])

}

}

}

Orchestration de build et déploiement

Compilation Maven avec agent Docker

stage('Maven Compilation') {

when { expression { env.SKIP_BUILD?.toBoolean() || params.FORCE?.toBoolean() } }

agent {

docker {

image 'maven:3.8.5-jdk-8-slim'

args '-v /var/jenkins_home/maven/.m2:/root/.m2'

}

}

steps {

script {

sh("mvn clean package -Dspring.profiles.active=${env.BRANCH_NAME}")

// Stash des artefacts pour agents suivants

sh "mkdir -p ${WORKSPACE}/build-output"

sh "cp target/*.jar ${WORKSPACE}/build-output/"

stash includes: 'build-output/*.jar', name: 'jar-files'

}

}

}

Build et Push des images Docker

stage('Build Docker Image') {

agent { label 'master' }

steps {

script {

unstash 'jar-files' // Récupération artefacts Maven

sh "cp ${WORKSPACE}/build-output/*.jar target/"

echo("🐳 Build image: ${dockers.img}")

sh("docker compose build --no-cache")

}

}

}

stage('Tag / Push Docker Images') {

steps {

script {

sh("docker tag ${env.DOCKER_IMAGE_NAME}:${env.IMAGE_VERSION} ${dockers.img}")

sh("docker push ${dockers.img}")

echo("✅ Image ${dockers.img} pushed to Nexus Registry")

}

}

}

Déploiement automatisé avec rollback

Mise à jour du projet distant

stage('Pull du projet') {

steps {

script {

String commande = "cd ${dockers.pathProjet} && " +

"git checkout ${env.BRANCH_NAME} && " +

"git pull origin ${env.BRANCH_NAME}"

utilsGit.gitPullSsh(remote, commande)

}

}

}

Déploiement Docker Swarm avec monitoring

stage('Update / Deploy') {

steps {

script {

echo("🚀 Deployment ${env.BRANCH_NAME} version ${env.BUILD}")

String deployCmd = "cd ${dockers.pathProjet} && " +

"./script/deploy.sh ${env.BUILD} ${env.BRANCH_NAME}"

utilsDocker.deployStack(deployCmd, true, remote)

}

}

}

stage('Vérification de disponibilité') {

steps {

script {

def maxRetries = 10

def retryDelay = 15

def success = false

for (int i = 1; i <= maxRetries; i++) {

try {

def response = sh(script:

"curl -s http://${remote.host}:${PORT}/actuator/health",

returnStdout: true).trim()

if (response.contains('"status":"UP"')) {

echo "✅ Service disponible après ${i} tentative(s)"

success = true

break

}

sleep time: retryDelay, unit: 'SECONDS'

} catch (Exception e) {

echo "⚠️ Tentative ${i}/${maxRetries} échouée: ${e.message}"

}

}

if (!success) {

error "⛔ Service indisponible après ${maxRetries} tentatives"

}

}

}

}

Publication automatique GitHub

stage('Publication du projet sur Github') {

steps {

script {

if (env.BUILD == 'beta') {

utilsGit.createOrUpdatePreRelease(

env.IMAGE_TAG,

env.REPO_NAME,

GITHUB_TOKEN,

params.PUBLIC_MESSAGE)

} else if (env.BUILD == 'release') {

utilsGit.createOrUpdateRelease(

env.IMAGE_TAG,

env.REPO_NAME,

GITHUB_TOKEN,

params.PUBLIC_MESSAGE)

}

}

}

}

Gestion d'erreurs et rollback automatique

post {

failure {

script {

if (!STATUS_STACK) {

echo("💥 Échec déploiement - Suppression stack ${dockers.stackName}")

utilsDocker.rmStack(dockers.stackName, true, remote)

} else {

echo("🔄 Échec mise à jour - Rollback stack ${dockers.stackName}")

utilsDocker.rollbackService(env.NAME_SERVICE, true, remote)

}

// Nettoyage image en échec

sleep time: 15, unit: 'SECONDS'

utilsDocker.rmi(dockers.img, true, remote)

}

}

success {

script {

echo("✅ Pipeline réussi - Version ${env.IMAGE_VERSION} déployée")

}

}

}

Monitoring et observabilité de la pipeline

Métriques de performance

- Tests unitaires : Rapports JUnit avec coverage

- Tests d'intégration : Validation base de données et APIs

- Tests E2E : Scénarios utilisateur complets

- Tests de régression : Validation non-régression via Postman

Artefacts et traçabilité

- Images Docker : Versioning beta/release avec metadata

- Rapports HTML : Newman, coverage, quality gates

- Logs centralisés : Chaque stage tracé avec corrélation

- GitHub Releases : Publication automatique avec changelogs

Cette architecture CI/CD garantit une qualité logicielle élevée avec des déploiements sécurisés et une traçabilité complète du cycle de développement à la production.

Défis techniques rencontrés et solutions

Le développement de cette architecture microservices a présenté de nombreux défis techniques complexes, particulièrement dans un contexte d'apprentissage autonome sans expertise préalable en DevOps et orchestration conteneurisée.

1. Intégration Eureka avec Docker Swarm Overlay Networks

Problème : Faire fonctionner le service discovery Eureka dans un environnement Docker Swarm avec des réseaux overlay, où les services doivent se découvrir à travers des réseaux virtuels distribués.

Complexité rencontrée :

- Les services Eureka s'enregistraient avec des adresses IP internes non routables

- Problèmes de résolution DNS entre les réseaux overlay Docker

- Conflits entre la découverte automatique Eureka et le service discovery natif Docker

Solution implémentée :

# Configuration Eureka optimisée pour Docker Swarm

eureka:

instance:

hostname: ms-eureka

preferIpAddress: true

instanceId: ${spring.application.name}:${random.int}

client:

registerWithEureka: false

fetchRegistry: false

serviceUrl:

defaultZone: http://ms-eureka:8761/eureka/

# Configuration réseau overlay

networks:

api:

external: true

name: spring-api # Réseau partagé entre tous les services

Configuration Gateway pour intégration Eureka/Docker :

spring:

cloud:

gateway:

discovery:

locator:

enabled: true

lowerCaseServiceId: true

routes:

- id: article-service

uri: lb://ms-article # Load balancing via Eureka

predicates:

- Path=/articles/**

Résultat : Service discovery hybride combinant la robustesse d'Eureka avec la simplicité des réseaux overlay Docker.

2. Orchestration des dépendances de démarrage - Script wait_for_config.sh

Problème : Assurer que le service de configuration centralisée (Spring Cloud Config) soit opérationnel avant le démarrage des autres microservices, évitant les échecs de démarrage en cascade.

Complexité rencontrée :

- Problèmes de timing lors du démarrage simultané des conteneurs

- Échecs intermittents de récupération de configuration

- Nécessité de gérer différents modes (développement vs production)

Solution développée :

#!/bin/bash

echo "Initialisation du service ms-article"

echo "PROFILE_ACTIF_SPRING=$PROFILE_ACTIF_SPRING"

echo "SERVICE_CONFIG_DOCKER=$SERVICE_CONFIG_DOCKER"

# Mode développement - bypass du Config Server

if [ "$PROFILE_ACTIF_SPRING" = "devDocker" ]; then

echo "Mode développement local - démarrage direct"

exec java -jar app.jar --spring.profiles.active=$PROFILE_ACTIF_SPRING

else

# Mode production - attente active du Config Server

while true; do

response=$(curl -s $SERVICE_CONFIG_DOCKER/actuator/health | jq -r '.status')

echo "Vérification Config Server: $SERVICE_CONFIG_DOCKER/actuator/health"

if [ "$response" == "UP" ]; then

echo "✅ Config Server opérationnel - Démarrage du service"

exec java -jar app.jar --spring.profiles.active=$PROFILE_ACTIF_SPRING

break

else

echo "⏳ Config Server non disponible - Retry dans 3s"

sleep 3

fi

done

fi

Innovation technique : Système de polling intelligent avec différentiation des environnements et logging détaillé pour debugging.

3. Health Checks métier pour Docker Swarm

Problème : Créer des vérifications de santé sophistiquées qui vont au-delà du simple ping réseau, permettant à Docker Swarm de détecter les dysfonctionnements applicatifs.

Complexité rencontrée :

- Les health checks Docker basiques ne détectent pas les problèmes métier

- Nécessité de vérifier la connectivité base de données, config server, etc.

- Gestion des logs de health check pour debugging

Solution personnalisée :

#!/bin/bash